本文中提及 AutoMQ 产品服务方、AutoMQ 服务方、AutoMQ,均特指 AutoMQ HK Limited及其附属公司。

操作流程

步骤 1:安装环境控制台

参考概述▸,AutoMQ 支持部署到 TKE 集群。在 TKE 部署模式下,首先仍然需要安装 AutoMQ 控制台,再通过控制台界面操作 TKE,将集群部署到 TKE。 腾讯云支持基于云应用安装环境控制台。参考从腾讯云云应用安装环境▸。 AutoMQ 控制台安装完成后,需要从控制台界面获取环境控制台地址、初始用户名、密码。步骤 2:创建 CAM 角色

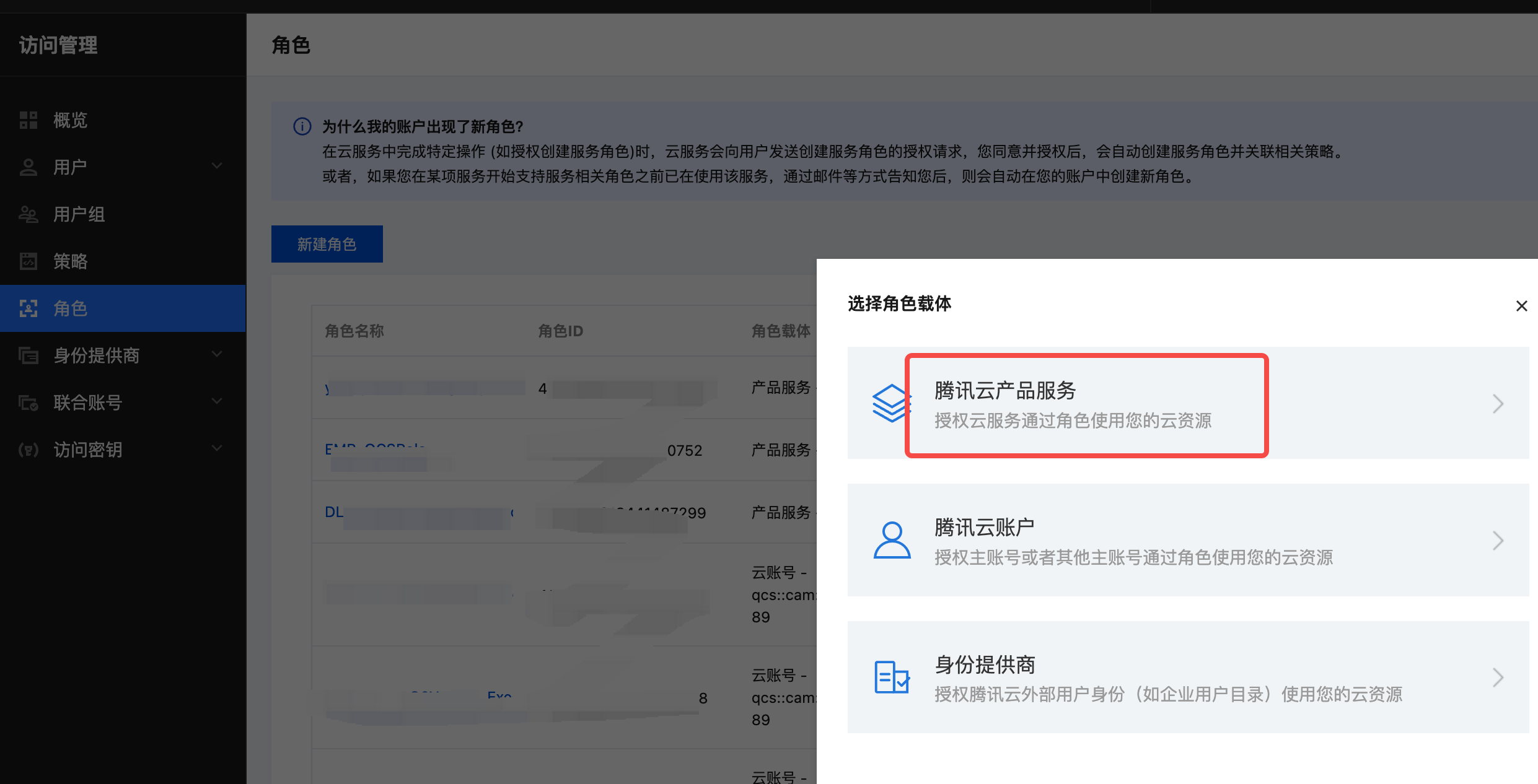

AutoMQ 数据面集群需要独立的节点池,该节点池需要绑定独立的 CAM 角色用于访问云资源的权限验证。因此,在创建 TKE 集群之前,需要前往 CAM 控制台创建自定义角色。操作步骤如下:- 前往 CAM 控制台,点击角色,新建角色, 选择腾讯云产品服务 。

- 选择产品服务 云服务器 CVM 。

- 输入自定义的角色名称,点击完成,创建自定义角色。记录角色名称,后续步骤 4 创建 TKE专属节点池需要配置角色名。

步骤 3:创建 TKE 集群

参考概述▸,用户需要提前创建独立的 TKE 集群分配给 AutoMQ 使用。用户可访问腾讯云 TKE 产品控制台按下方步骤操作。- 登录腾讯云 TKE 控制台。点击创建集群 。

- 选择集群类型为标准集群。

- 填写基础配置 ,注意集群规格等信息,建议至少选择 L20 ,并开启自动升配。其他参数保持默认值即可。

建议至少选择 L20,管理 20 个左右节点,并开启自动升配。防止因 TKE 能力不足导致无法扩缩容。

- 填写网络配置, 选择正确的 VPC,网络插件选择推荐的 VPC-CNI,容器子网选择所有需要的可用区。

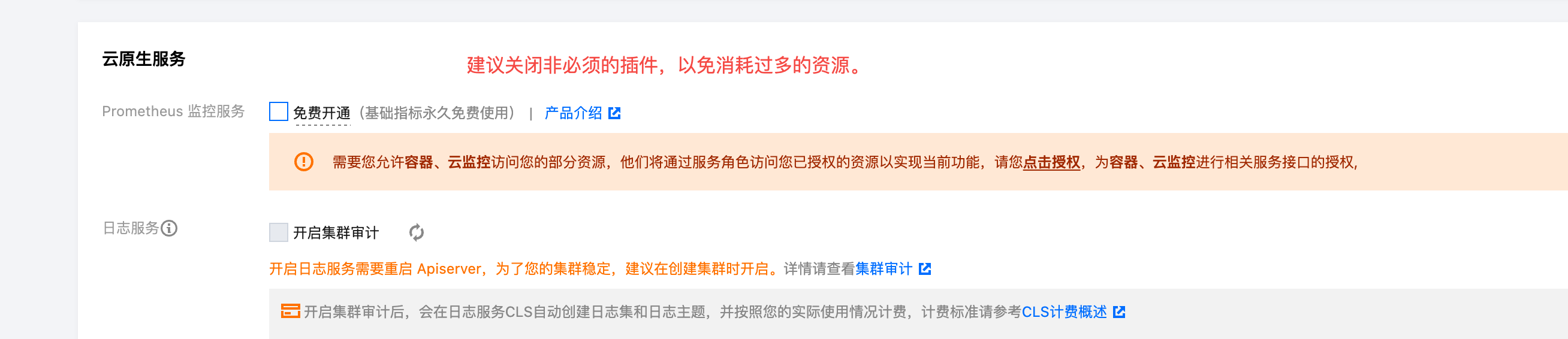

- 点击下一步,关闭非必须的 Prometheus 插件,完成创建 。

步骤 4:创建 TKE 公共节点池

参考概述▸,用户需要为 TKE 集群 创建一个公共节点池,用于部署 TKE 系统组件。参考以下步骤创建符合要求的节点池。- 进入步骤 2 创建的 TKE 集群详情,点击节点菜单 ,创建节点池 。

- 选择普通节点池类型, 参考下面的文档设置自定义参数,完成节点池创建。对于表格中没有说明的参数,请按照默认推荐值不要修改。

| 设置参数 | 取值说明 |

|---|---|

| 节点池名称 |

|

| 机型配置 |

|

| 初始节点数量 |

|

步骤 5:创建 AutoMQ 专用 TKE 节点池

参考概述▸,用户需要为 AutoMQ 创建符合要求的专用节点池,以便后续部署实例申请机器。参考以下步骤创建符合要求的节点池,并完成委托授权。- 进入步骤 2 创建的 TKE 集群详情,点击节点菜单 ,创建节点池 。

- 选择普通节点池类型, 参考下面的文档设置自定义参数,完成节点池创建。对于表格中没有说明的参数,请按照默认推荐值不要修改。

| 设置参数 | 取值说明 |

|---|---|

| 节点池名称 |

|

| 机型配置 |

注意:AutoMQ 必须运行在指定机型的 VM 中,创建节点池如果选择了非预设的机型,后续无法使用该节点池。 |

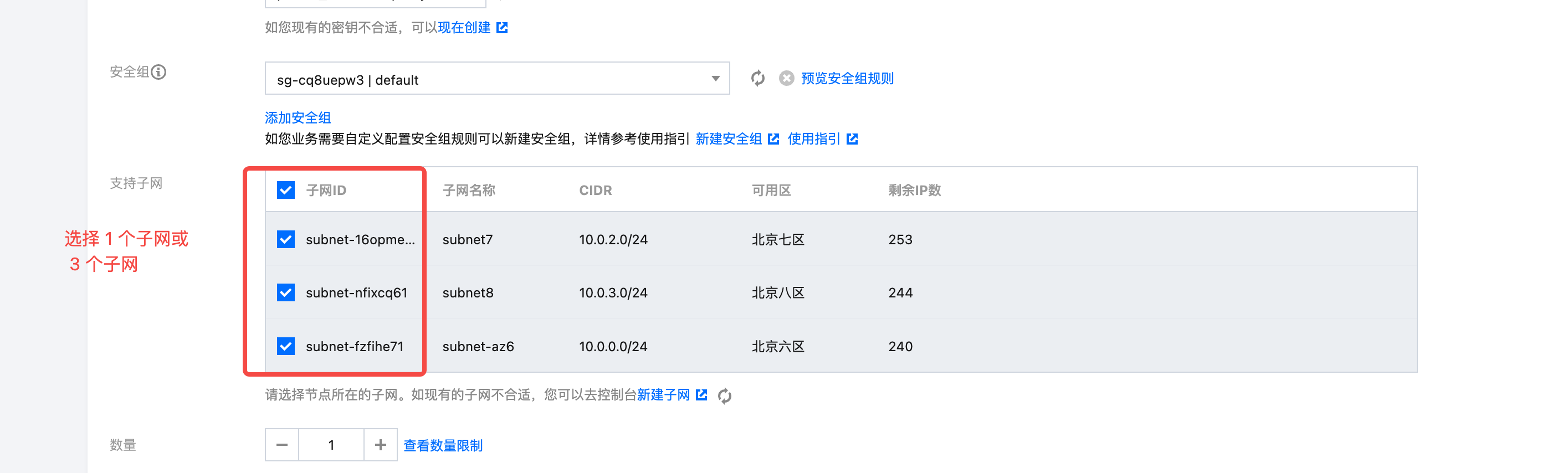

| 支持子网 |

注意: AutoMQ 要求后续创建集群的可用区和节点池必须完全一致。因此,如果需要创建单可用区的 AutoMQ 集群,则此处创建单可用区节点池;如果需要创建三可用区 AutoMQ 集群,则此处同样创建三可用区节点池,两者不可混用。 |

| CAM 角色 |

|

| 污点 |

|

- 节点启动配置, 选择一个或三个子网,初始数量为 1。

- 填写运维功能设置, 选择开启弹性伸缩,节点数量设置至少为 1,弹性上限建议和 TKE 集群规格以及未来需要部署 AutoMQ 的机器规模一致。实例创建策略,选择多可用区打散。

- 为节点池绑定 CAM 角色 ,信息来自 安装控制台后的输出参数 。然后点击创建节点池。 添加 AutoMQ 独占的污点。污点的键是dedicated,值是 automq,效果是 NO_SCHEDULE。

- 为 AutoMQ 使用的节点组创建 Placeholder Deployment 用于加速节点故障场景的 Failover 速度。

automq-low-priority.yaml 的优先级申明文件,执行以下命令,创建优先级申明。

automq-tke-placeholder.yaml 文件。需要根据实际部署的节点池,修改其中的参数:

-

metadata.name: 建议修改成具有意义的 Placeholder 名称,例如placeholder-for-nodegroup-A。 -

replicas: Placeholder pod 预留数量,默认为 1,如果是多可用区部署,建议每个可用区保留 1 台机器,即数量设置为可用区的数量。 -

affinity.nodeAffinity: 用于选择 Placeholder 部署的节点,需要修改matchExpressions中的key和values来精确匹配 AutoMQ 的节点池。在示例的 yaml 文件中提供 2 个选项筛选节点。-

eks.tke.cloud.tencent.com/nodegroup-id:在 TKE 上使用eks.tke.cloud.tencent.com/nodegroup-id标签筛选指定的节点池。 -

node.kubernetes.io/instance-type:在 TKE 上使用node.kubernetes.io/instance-type标签筛选指定的节点机型。

-

-

resources:- limits 的 cpu/memory 与 Node Group 具体的规格保持一致,比如2C16G 。

- requests 的 cpu/memory 略小于 Node Group 具体的规格,比如实际占用 3/4 比例,确保 Placeholder Pod 能调度到额外 Node 并保证独占效果,避免集群其他 Pod 非预期占用导致实际 Failover 时因资源不足调度失败。

Running ,并观察它是否被调度到了期望的节点上。

步骤 6:进入环境控制台,创建部署配置

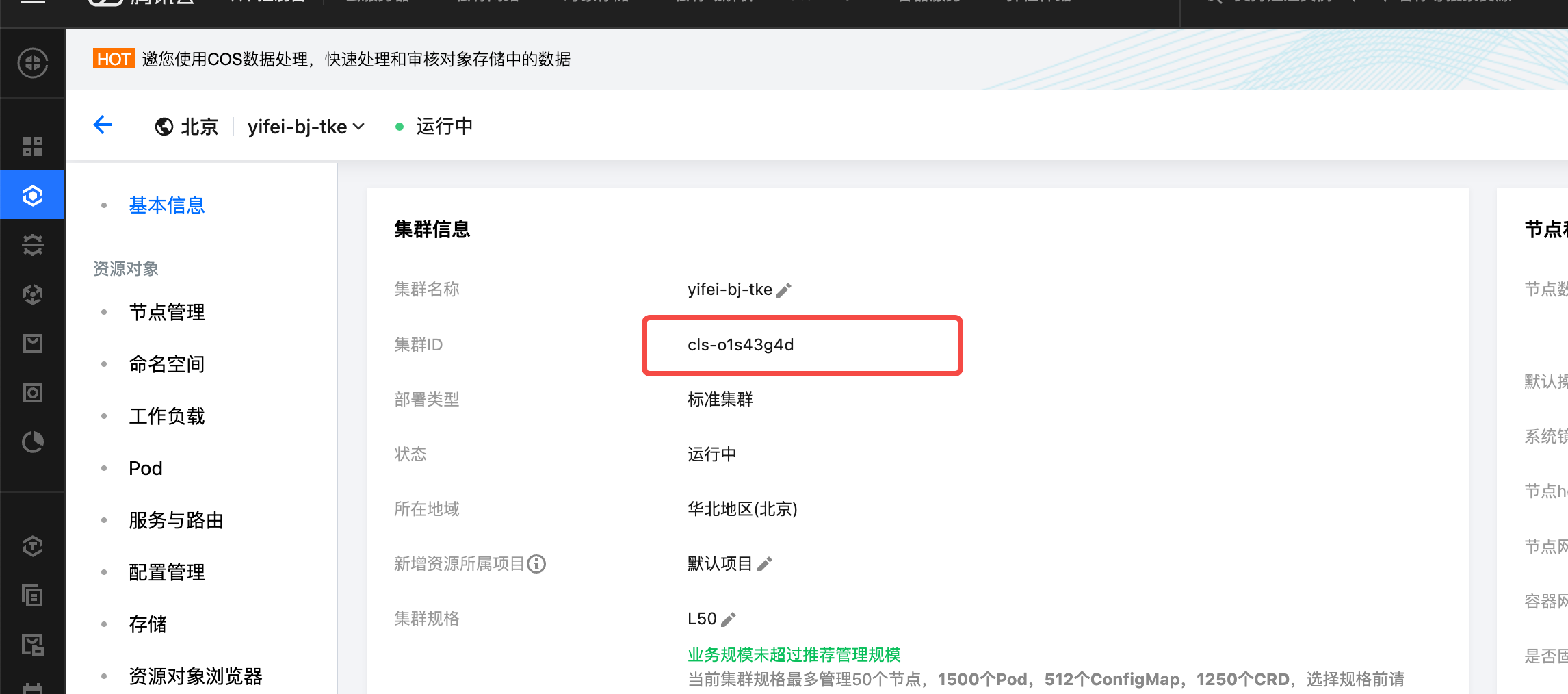

首次进入 AutoMQ BYOC 控制台,需要创建部署配置,用于设置 Kubernetes 集群信息、OBS Bucket 等信息,之后才可创建实例。- 复制步骤2 创建的 TKE 集群的集群 ID 。

- 找到 APIServer 配置菜单,获取 Kubeconfig 配置文件。

-

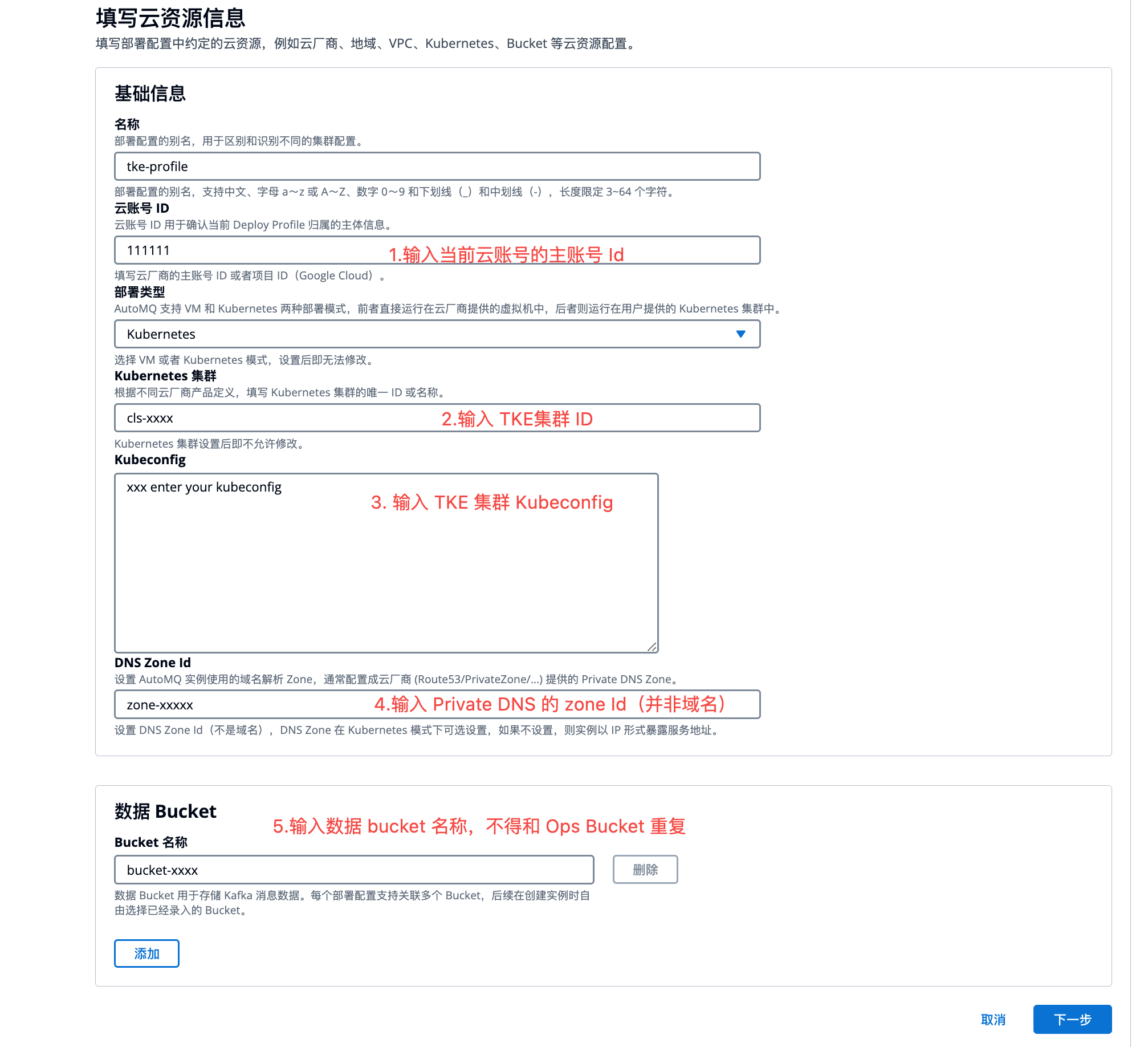

登录控制台,录入集群 ID 和 Kubeconfig 等配置,点击下一步。

- 云账号 ID:填写当前的云账号主账号 ID,从腾讯云控制台查看。

- 部署类型:选择 Kubernetes。

- Kubernetes 集群:填写 TKE 集群的集群 ID。

- Kubeconfig:填写上一步复制的内容。

- DNS ZoneId:填写用于部署 AutoMQ 的 Private DNS 的 ZoneId。

- Bucket 名称:填写用于部署 AutoMQ 存储消息的数据 Bucket,支持添加多个 COS Bucket。

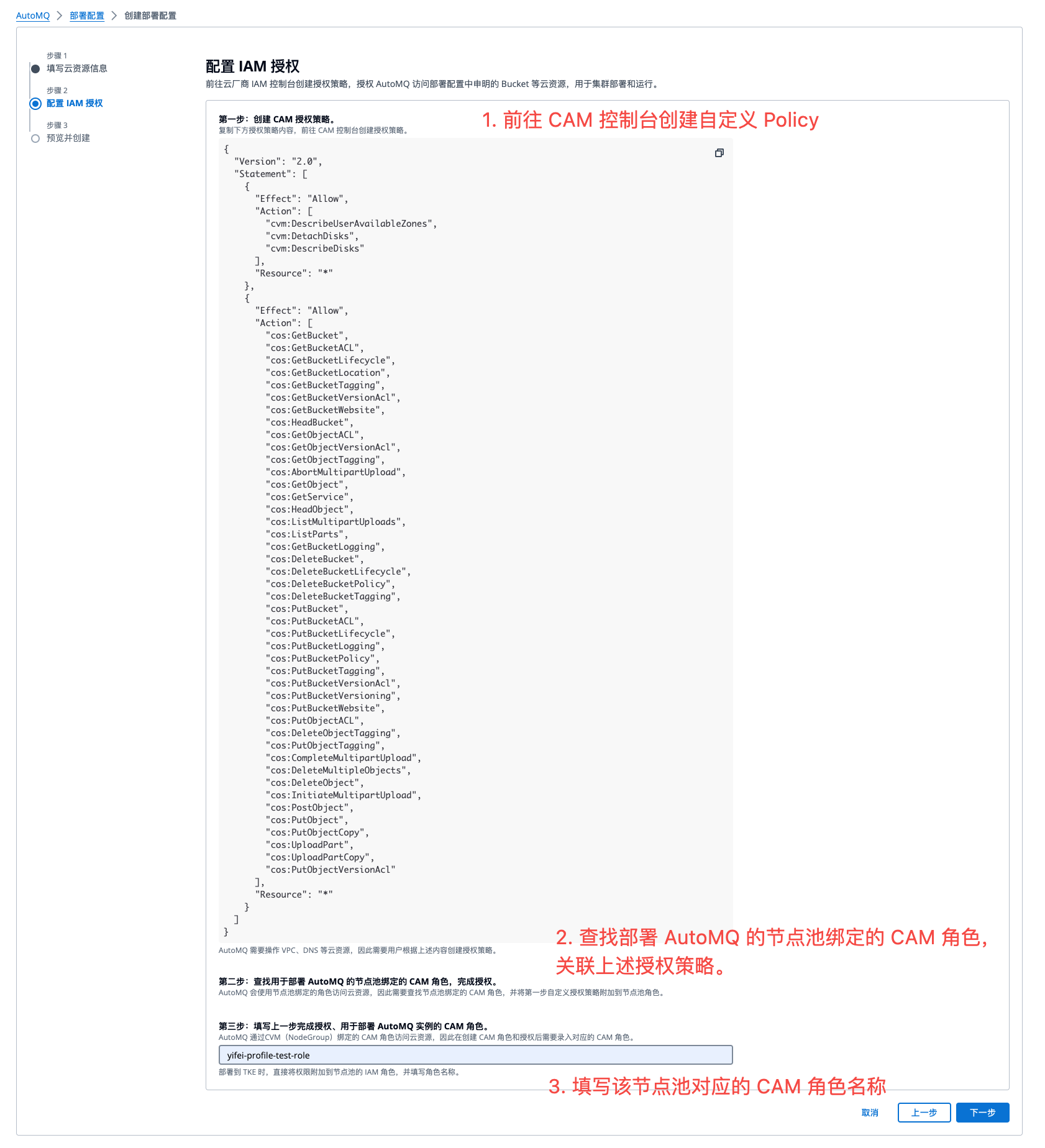

- 填写云资源信息后,生成数据面 TKE 节点池需要授权的权限。参考控制台指引,创建自定义授权策略 。然后将授权策略绑定到步骤 2 创建的 AutoMQ CAM 角色,并录入该节点池角色名称 ,点击下一步预览 。

- 预览部署配置信息,完成创建 。即可前往实例管理页面创建实例。